L’obsolescence technique n’est pas une fatalité, mais le symptôme d’une architecture de confiance défaillante.

- Les mises à jour tardives et les sauvegardes locales ne sont que la partie visible du problème.

- La vraie menace réside dans les points de rupture invisibles : limitations d’hébergement, contenu mixte et choix technologiques inadaptés.

Recommandation : Adopter une architecture de vigilance prédictive pour transformer les coûts de maintenance réactive en investissement durable.

En tant que DSI ou responsable informatique, vous avez investi des ressources considérables dans votre présence numérique. Pourtant, un sentiment de précarité demeure : ce site web, autrefois performant, semble vieillir prématurément. Les performances déclinent, la maintenance devient un gouffre financier et la moindre mise à jour se transforme en projet à haut risque. Cette spirale, souvent qualifiée d’obsolescence technique programmée, n’est pas une fatalité inéluctable mais le résultat d’une approche réactive, focalisée sur la correction des symptômes plutôt que sur le traitement des causes profondes.

La sagesse populaire conseille de mettre à jour son CMS, de choisir des technologies robustes et d’effectuer des sauvegardes régulières. Bien que nécessaires, ces actions s’apparentent souvent à appliquer des pansements sur une structure fragilisée. Elles ne répondent pas aux questions fondamentales de l’architecture. Et si le véritable enjeu n’était pas de lutter contre la technologie vieillissante, mais de construire un écosystème numérique dont la durabilité est pensée dès sa conception ? La clé ne réside pas dans une maintenance effrénée, mais dans la mise en place d’une architecture de confiance et d’un système de vigilance prédictive.

Cet article n’est pas une simple checklist de bonnes pratiques. Il s’agit d’un guide stratégique pour identifier les points de rupture systémiques de votre infrastructure web. Nous allons déconstruire les mythes de la maintenance classique pour vous donner les moyens de bâtir une architecture résiliente, capable d’anticiper les failles avant qu’elles ne deviennent des crises et de garantir la pérennité de vos investissements numériques sur le long terme.

Pour vous guider dans cette démarche proactive, nous avons structuré cet article autour des points de défaillance les plus critiques. Vous découvrirez comment chaque composant de votre écosystème, de l’hébergement à la gestion des plugins, contribue à la résilience globale de votre site.

Sommaire : Protéger son site de l’obsolescence technique, une approche d’architecte

- Hébergement mutualisé ou dédié : à quel niveau de trafic devez-vous migrer ?

- Pourquoi retarder la mise à jour de vos plugins expose vos données clients ?

- L’erreur de sauvegarde qui vous empêchera de restaurer votre site après un hack

- Comment préparer votre base de données pour supporter les soldes sans crasher ?

- Quels signes indiquent que votre technologie actuelle freine votre croissance ?

- L’erreur d’appeler une image en HTTP sur une page HTTPS qui brise votre sécurité

- WordPress ou solution sur-mesure : quel choix pour un site vitrine de 50 pages ?

- Pourquoi un cadenas vert ne suffit plus pour rassurer Google et vos clients ?

Hébergement mutualisé ou dédié : à quel niveau de trafic devez-vous migrer ?

Le choix de l’hébergement est souvent perçu comme une décision initiale, figée dans le temps. C’est une erreur stratégique majeure. Un hébergement mutualisé, parfait au lancement, devient un goulot d’étranglement à mesure que votre trafic augmente. Le véritable indicateur n’est pas le nombre de visites, mais le nombre de connexions simultanées que votre architecture peut supporter. La plupart des offres mutualisées imposent des limites strictes, souvent autour de 30 connexions simultanées maximum à la base de données, créant un point de rupture invisible qui se manifeste par des erreurs « 503 Service Unavailable » lors des pics d’activité.

Ce plafond n’est pas une simple contrainte technique, c’est une limite directe à votre potentiel de croissance. Un site qui tombe pendant une campagne marketing ou une période de soldes n’est pas seulement une perte de revenus immédiate, c’est aussi un signal négatif envoyé à vos clients et aux moteurs de recherche. La migration vers un serveur dédié ou une solution cloud scalable n’est donc pas un luxe, mais une nécessité architecturale dès que votre activité dépasse le stade de la simple vitrine.

Étude de cas : Le point de rupture d’un blog à succès

Un blog générant entre 5 000 et 6 000 pages vues par jour, hébergé sur une offre mutualisée standard chez OVH, a commencé à subir des erreurs SQL récurrentes. L’analyse a révélé que la limite de 10 connexions simultanées à la base de données était constamment atteinte lors des pics de 30 à 40 visiteurs en même temps. La migration vers une solution de base de données privée, capable de gérer cette charge, a été la seule solution pour stabiliser le site et ne plus perdre de trafic qualifié.

Anticiper ce point de rupture relève de la vigilance prédictive. Il est impératif de monitorer l’utilisation des ressources (CPU, RAM, I/O disque) et d’analyser les logs serveur pour détecter les premiers signes de saturation. Attendre le crash pour réagir, c’est accepter une interruption de service et une dégradation de l’expérience utilisateur qui auraient pu être évitées.

Pourquoi retarder la mise à jour de vos plugins expose vos données clients ?

Considérer les mises à jour de plugins comme une tâche de maintenance secondaire est l’une des failles les plus courantes et les plus dangereuses dans l’architecture de confiance d’un site web. Chaque plugin est une porte d’entrée potentielle vers votre système. Un plugin non mis à jour n’est pas simplement une fonctionnalité qui risque de ne plus fonctionner ; c’est une vulnérabilité connue et documentée, une invitation ouverte pour les attaquants. Les statistiques sont sans appel : selon les données sectorielles, 43% des cyberattaques ciblent les petites entreprises, souvent en exploitant des failles logicielles non corrigées.

Le risque va bien au-delà d’un simple défaçage de votre page d’accueil. Une faille dans un plugin peut permettre l’injection de malwares, le vol de données clients (noms, adresses, informations de paiement) ou l’utilisation de votre serveur pour des activités illégales. La non-mise à jour constitue une négligence qui engage directement votre responsabilité, notamment dans le cadre du RGPD. La question n’est plus « faut-il mettre à jour ? », mais « comment mettre à jour de manière sécurisée et systématique ? ».

Une approche professionnelle ne consiste pas à cliquer sur « mettre à jour » dès qu’une notification apparaît. Elle exige un protocole rigoureux pour éviter de casser le site tout en comblant les failles. Cela implique de tester les mises à jour sur un environnement de pré-production (staging), de vérifier les journaux de modifications (changelogs) pour identifier les correctifs de sécurité (CVE), et de planifier ces interventions pour minimiser l’impact sur les utilisateurs. De plus, un audit régulier des plugins permet d’identifier et de remplacer ceux qui sont abandonnés par leurs développeurs (abandonware), car ils représentent une dette technique qui ne fera que croître.

Plan d’action pour un protocole de mise à jour sécurisée

- Effectuer une sauvegarde complète du site et de la base de données avant toute intervention.

- Consulter les changelogs pour identifier les failles de sécurité corrigées (CVE) et les changements majeurs.

- Déployer et tester les mises à jour sur un environnement de staging, copie conforme de la production.

- Privilégier les mises à jour manuelles et planifiées en dehors des heures de pointe plutôt que les mises à jour automatiques non contrôlées.

- Identifier et planifier le remplacement des plugins abandonnés (non mis à jour depuis plus d’un an) pour maîtriser la dette technique.

L’erreur de sauvegarde qui vous empêchera de restaurer votre site après un hack

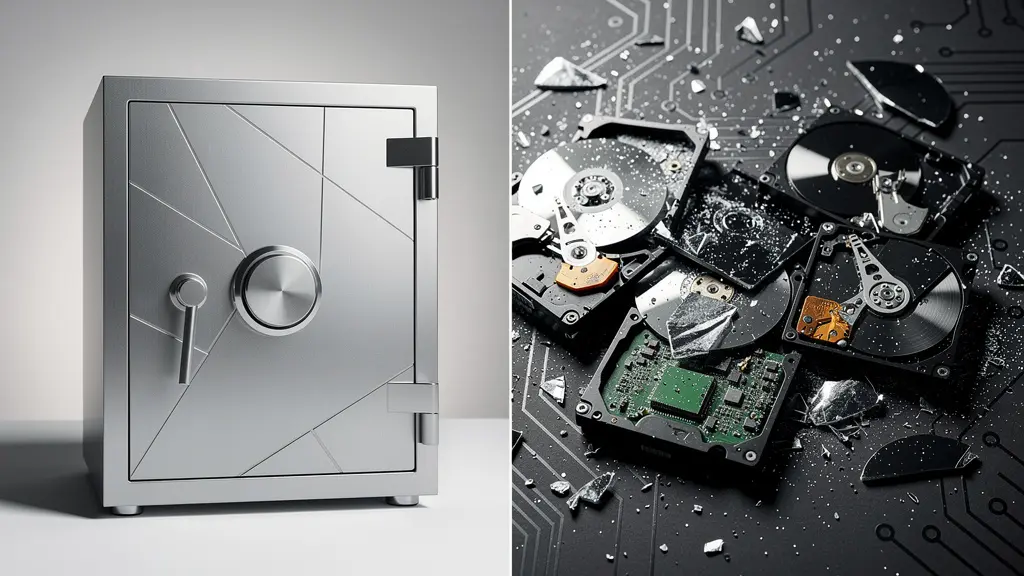

La plupart des responsables informatiques pensent avoir une stratégie de sauvegarde solide. En réalité, beaucoup commettent une erreur architecturale fondamentale : stocker les sauvegardes sur le même serveur que le site en production. C’est l’équivalent de conserver le double de vos clés de maison sous le paillasson. En cas de hack, d’infection par un ransomware ou de défaillance matérielle du serveur, votre site et ses sauvegardes disparaîtront simultanément, rendant toute restauration impossible. C’est un point de défaillance unique qui anéantit toute votre stratégie de résilience applicative.

Une sauvegarde n’a de valeur que si elle est externe, immuable et testée. Les solutions professionnelles n’automatisent pas seulement la sauvegarde, elles l’externalisent sur une infrastructure totalement indépendante. Cette dissociation est la seule garantie de pouvoir restaurer une version saine de votre site, même si votre hébergement principal est complètement compromis et inaccessible.

Comme le montre ce schéma, la stratégie de droite, où les sauvegardes sont sur le même serveur, est une illusion de sécurité. En cas de sinistre majeur, tout est perdu. La stratégie de gauche, avec un stockage externe sécurisé, est la seule qui assure une véritable continuité d’activité. La mise en place de sauvegardes fiables ne se limite pas à cocher une case ; elle doit suivre des principes stricts :

- Automatisation : Les sauvegardes doivent être automatiques et fréquentes (quotidiennes pour un site actif).

- Externalisation : Elles doivent être stockées sur un serveur distant, idéalement dans un autre data center.

- Rétention : Conserver plusieurs versions sur une période d’au moins 30 jours pour pouvoir revenir à un état antérieur à une infection.

- Test : La procédure de restauration doit être testée régulièrement pour garantir son efficacité le jour J.

Étude de cas : L’assurance d’une restauration en un clic

L’agence Orbitis, qui gère la maintenance de plus de 600 sites, a adopté la solution BlogVault. Ce service n’effectue pas seulement des sauvegardes quotidiennes, il les stocke sur ses propres serveurs Amazon S3. Cette architecture leur permet de garantir une restauration en un clic, même si le site du client ou son serveur d’hébergement est totalement hors service. Cet investissement annuel prévient des pertes de données et des interruptions de service qui coûteraient bien plus cher.

Comment préparer votre base de données pour supporter les soldes sans crasher ?

La base de données est le moteur de votre site web. Lors d’un pic de trafic, comme pendant les soldes, ce moteur est poussé à ses limites. Un site e-commerce qui devient lent ou inaccessible durant cette période cruciale subit une perte de chiffre d’affaires directe et une dégradation durable de son image. Préparer sa base de données n’est pas une simple optimisation, c’est une mesure préventive essentielle pour garantir la performance et la stabilité lorsque chaque seconde compte. L’obsolescence se manifeste ici par une incapacité de l’architecture à s’adapter à la charge (à « scaler »).

La première ligne de défense est une stratégie de mise en cache intelligente. Le cache permet de servir des versions pré-calculées des pages et des requêtes, soulageant ainsi la base de données d’un travail répétitif. Il ne s’agit pas d’une solution unique, mais d’une combinaison de plusieurs couches de cache, chacune répondant à un besoin spécifique. Pour un DSI, comprendre ces nuances est crucial pour choisir la bonne architecture.

Le tableau suivant compare différentes solutions de cache et leur impact, montrant qu’une approche multi-niveaux est souvent la plus efficace pour les sites à fort trafic.

| Solution | Type de cache | Impact performance | Adapté pour |

|---|---|---|---|

| Cache de page simple | HTML statique | +50% vitesse | Sites vitrines |

| Object Caching (Redis) | Requêtes SQL | +80% réduction charge DB | E-commerce avec filtres |

| Memcached | Sessions/données temporaires | +70% réduction I/O | Sites à fort trafic |

| CDN + Cache | Fichiers statiques | +90% vitesse globale | Audience internationale |

Au-delà du cache, une maintenance proactive de la base de données est indispensable. Avant un pic de trafic anticipé, plusieurs actions doivent être menées pour assurer des performances optimales :

- Nettoyage des données transitoires (transients) : Ces données temporaires peuvent s’accumuler et ralentir les requêtes.

- Optimisation des tables : Lancer une commande `OPTIMIZE TABLE` sur les tables les plus sollicitées réorganise les données et améliore la vitesse d’accès.

- Création d’index : Ajouter des index sur les colonnes de la base de données qui sont fréquemment utilisées dans les clauses `WHERE` (ex: filtres de recherche) accélère drastiquement les requêtes.

- Monitoring des requêtes lentes : Activer et analyser les logs de « Slow Queries » permet d’identifier et d’optimiser les requêtes qui consomment le plus de ressources.

Quels signes indiquent que votre technologie actuelle freine votre croissance ?

L’obsolescence technique n’est pas toujours un événement brutal comme un piratage. Le plus souvent, c’est une dégradation lente et insidieuse qui se manifeste par des frictions croissantes et des coûts qui explosent. Cette dette technique invisible finit par freiner concrètement la croissance de l’entreprise. En tant que DSI, votre rôle est de détecter les signaux faibles avant qu’ils ne se transforment en obstacles insurmontables. L’un des indicateurs les plus fiables est l’augmentation exponentielle du temps et du coût de la maintenance.

Quand la moindre modification ou l’ajout d’une nouvelle fonctionnalité demande des semaines de développement et des tests de régression complexes, c’est que votre socle technologique est devenu rigide. Selon les experts en maintenance applicative, sur une technologie obsolète, le temps de maintenance peut être multiplié par 10 par rapport à un environnement moderne. Cet effort n’est pas un investissement, mais une dépense pour maintenir à flot un navire qui prend l’eau.

Cette image illustre parfaitement la transition d’un circuit ancien, corrodé et inefficace vers des composants modernes et performants. Les autres signaux d’alerte qui doivent déclencher une réflexion sur une migration ou une refonte sont :

- Incompatibilité avec les nouvelles technologies : Votre site ne peut pas s’intégrer facilement avec de nouvelles API, des services tiers ou des outils marketing modernes.

- Difficulté de recrutement : Vous peinez à trouver des développeurs compétents sur vos technologies vieillissantes (anciennes versions de PHP, frameworks dépassés).

- Performances dégradées : Malgré les optimisations, les temps de chargement restent élevés et impactent votre SEO et l’expérience utilisateur.

- Failles de sécurité récurrentes : Vous passez plus de temps à colmater des brèches qu’à développer de nouvelles fonctionnalités.

Étude de cas : Le coût exorbitant de l’attentisme

Une PME a ignoré pendant trois ans les alertes d’obsolescence de son CMS propriétaire. Lorsque le système est devenu totalement instable et non sécurisé, elle a été contrainte à une migration d’urgence. Le coût de cette opération, réalisée dans la précipitation, a été cinq fois supérieur à celui d’une migration planifiée. Pire encore, l’entreprise a subi deux semaines d’interruption de service partielle, avec un impact direct sur son chiffre d’affaires et sa réputation.

L’erreur d’appeler une image en HTTP sur une page HTTPS qui brise votre sécurité

La migration de votre site en HTTPS, symbolisée par le cadenas dans la barre d’adresse, est une étape fondamentale pour bâtir une architecture de confiance. Cependant, une erreur fréquente vient saper cet effort : le « mixed content » ou contenu mixte. Ce problème survient lorsqu’une page sécurisée (chargée en HTTPS) contient des ressources (images, scripts, feuilles de style) qui sont encore appelées via une URL non sécurisée (en HTTP). Cette micro-fissure, bien que souvent invisible pour l’utilisateur, compromet la sécurité de toute la page.

Les navigateurs modernes ont adopté une politique de plus en plus stricte face à ce problème. Ils bloquent systématiquement le contenu mixte « actif » (comme les scripts), ce qui peut casser des fonctionnalités essentielles de votre site. Pour le contenu mixte « passif » (comme les images), ils affichent un avertissement de sécurité qui dégrade la confiance de l’utilisateur et peut nuire à votre référencement. Comme le souligne une source d’autorité en la matière, les conséquences sont directes.

Les navigateurs modernes bloquent désormais automatiquement le contenu mixte actif et avertissent pour le contenu passif, impactant directement l’expérience utilisateur et le référencement.

– Mozilla Developer Network, Documentation sur la sécurité web MDN 2024

La correction du contenu mixte n’est pas une option. C’est une obligation pour garantir l’intégrité de votre connexion sécurisée. La démarche consiste à scanner l’intégralité du site pour identifier toutes les ressources appelées en HTTP, puis à mettre à jour leurs URLs en HTTPS, que ce soit dans les fichiers du thème ou directement dans la base de données. Pour une protection durable, il est recommandé d’implémenter l’en-tête de sécurité HTTP `Content-Security-Policy` (CSP) avec la directive `upgrade-insecure-requests`. Cette dernière demande au navigateur de tenter de transformer automatiquement toutes les requêtes HTTP en HTTPS, agissant comme un filet de sécurité contre les oublis.

WordPress ou solution sur-mesure : quel choix pour un site vitrine de 50 pages ?

Le choix entre un CMS open-source comme WordPress et une solution développée sur-mesure est une décision architecturale structurante. Pour un site vitrine, même conséquent (50 pages), la tentation du sur-mesure peut sembler séduisante, promettant une solution parfaitement adaptée. Cependant, cette approche crée souvent une dette technique et des coûts de possession (TCO) bien plus élevés à long terme. L’obsolescence d’une solution sur-mesure est souvent plus rapide et plus coûteuse à gérer, car vous dépendez entièrement de l’agence ou du développeur qui l’a créée.

Un CMS comme WordPress, soutenu par une immense communauté, bénéficie de mises à jour de sécurité constantes, d’un vaste écosystème de plugins pour l’évolutivité, et d’une portabilité des données standardisée. La maintenance et les évolutions sont moins coûteuses car les compétences sont largement disponibles sur le marché. L’analyse du coût total de possession sur 5 ans est éclairante et doit guider la décision d’un DSI.

Le tableau suivant, basé sur des moyennes de marché, démontre que le coût initial plus élevé du sur-mesure est aggravé par des frais de maintenance annuels significativement supérieurs.

| Critère | WordPress | Solution sur-mesure |

|---|---|---|

| Coût initial | 3 000-8 000€ | 15 000-30 000€ |

| Maintenance annuelle | 500-1 500€ | 2 000-5 000€ |

| Évolutions fonctionnelles | Plugins disponibles | Développement spécifique |

| Portabilité des données | Export XML natif | Dépend de l’architecture |

| SEO technique | Standards intégrés | À développer |

| TCO sur 5 ans | 5 500-15 500€ | 25 000-55 000€ |

Étude de cas : La migration rentable vers WordPress

Une PME, disposant d’un site sur-mesure de 60 pages datant de 2019, a vu ses coûts de maintenance annuels dépasser 5 000 €. Face à cette charge et à la rigidité du système, elle a décidé de migrer vers WordPress. L’opération a coûté 8 000 € en une fois, mais a permis de réduire les frais de maintenance de 75 % dès la première année, tout en améliorant les performances SEO de 40 % grâce aux outils natifs du CMS.

À retenir

- L’obsolescence est une défaillance de l’architecture de confiance, pas seulement du code.

- La protection passe par une vigilance prédictive (monitoring, tests) plutôt que par une maintenance réactive.

- Chaque choix technique (hébergement, CMS, plugins) doit être évalué en termes de TCO et de résilience à long terme.

Pourquoi un cadenas vert ne suffit plus pour rassurer Google et vos clients ?

Pendant des années, le cadenas vert et le préfixe HTTPS ont été le symbole universel de la sécurité en ligne. Pour un DSI, obtenir ce certificat était un objectif clair. Aujourd’hui, ce symbole a perdu une grande partie de sa valeur. La raison est simple : les cybercriminels l’ont adopté massivement. D’après les analyses de sécurité web récentes, plus de 80% des sites de phishing utilisent désormais des certificats SSL valides. Le cadenas ne garantit plus que le site est légitime ; il prouve seulement que la connexion entre vous et le serveur est chiffrée, même si ce serveur appartient à un escroc.

Par conséquent, l’architecture de confiance ne peut plus reposer sur ce simple indicateur. Google et les utilisateurs avertis recherchent désormais des signaux de confiance plus profonds. L’obsolescence se situe ici au niveau de la stratégie de réassurance. Ne communiquer que sur le SSL, c’est tenir un discours dépassé qui n’adresse plus les craintes réelles des utilisateurs. Pour construire une confiance durable, il faut aller au-delà du cadenas et mettre en œuvre un ensemble de mesures techniques et communicationnelles.

Renforcer la confiance est un travail continu qui repose sur la transparence et la robustesse de votre architecture globale. Les actions suivantes sont devenues des standards pour les entreprises qui prennent la sécurité au sérieux :

- Implémenter HSTS (HTTP Strict Transport Security) : Cet en-tête de sécurité force le navigateur à n’utiliser que des connexions HTTPS avec votre site, éliminant le risque d’attaques de type « man-in-the-middle ».

- Afficher des sceaux de sécurité tiers : Des badges provenant d’audits de sécurité reconnus (Norton, McAfee) peuvent rassurer les visiteurs.

- Publier une politique de confidentialité claire : Un document accessible, complet et conforme au RGPD démontre votre engagement envers la protection des données.

- Activer l’authentification à deux facteurs (2FA) : Proposer cette option pour les comptes clients est un signal fort de votre souci de leur sécurité.

- Communiquer sur vos mesures de sécurité : Dédier une page de votre site à expliquer, en termes simples, les mesures que vous prenez pour protéger vos clients.

L’ère du cadenas vert comme unique gage de confiance est révolue. La sécurité est désormais un argument qui doit être prouvé par une architecture solide et une communication transparente.

Pour commencer à bâtir une architecture numérique durable et protéger vos investissements, la première étape consiste à réaliser un audit complet de votre écosystème actuel afin d’identifier vos propres points de rupture.